目次

- 革新的な脳型AI「Lp-Convolution」がコンピュータビジョンを変革

- ロボットがHow-to動画から学習する「RHyME」フレームワーク

- 脳信号を自然な音声にリアルタイム変換する画期的技術

- AI技術の今後の発展と私たちの生活への影響

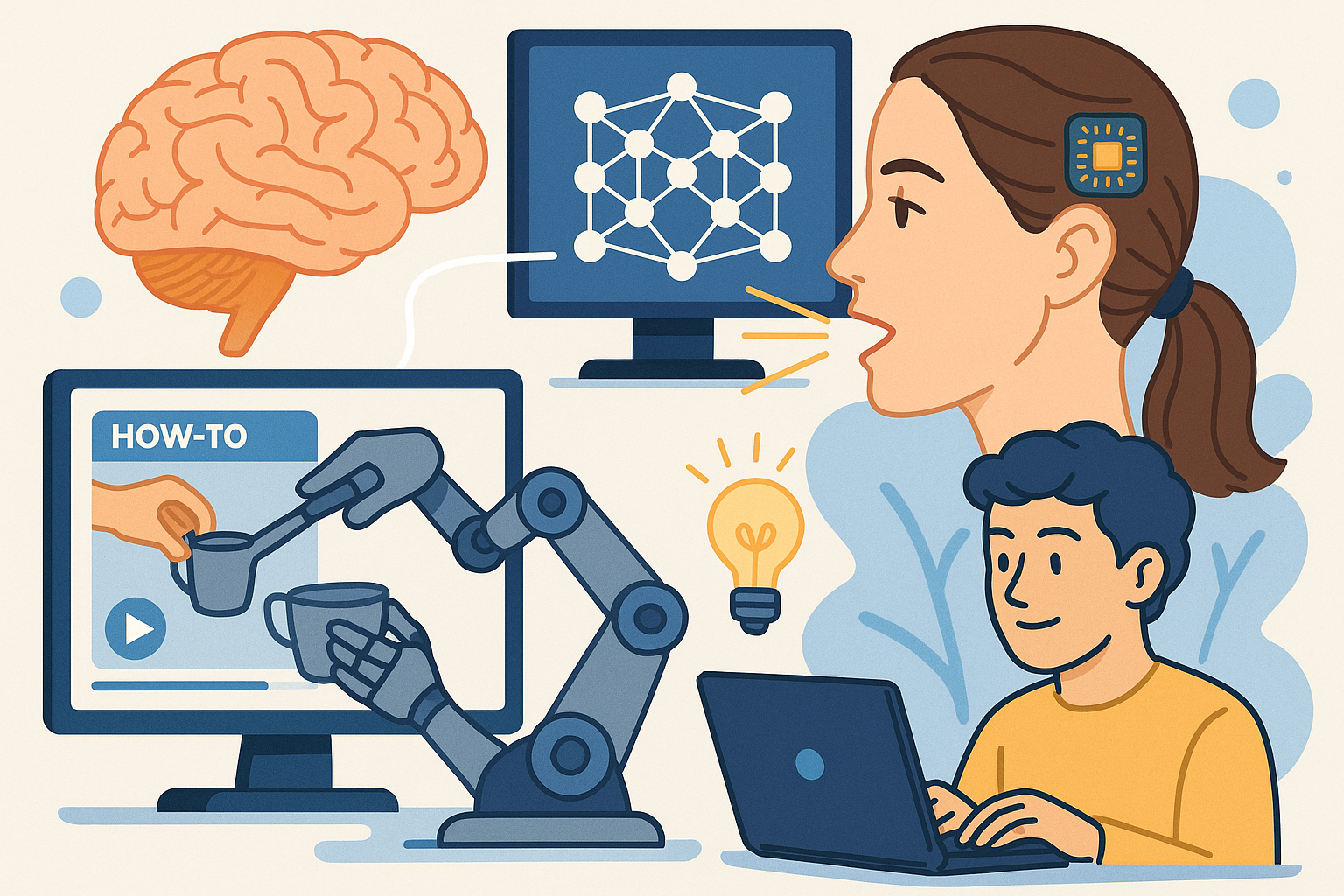

人工知能(AI)の進化は驚異的なスピードで進んでいます。2025年5月現在、研究者たちは人間の脳の仕組みを模倣し、より効率的で自然な方法でタスクを実行できる新しいAIシステムを開発しています。これらの技術革新は、コンピュータビジョン、ロボット工学、医療分野などで大きなブレイクスルーをもたらしています。本記事では、最近発表された3つの画期的なAI技術に焦点を当て、その仕組みと潜在的な影響について詳しく解説します。

革新的な脳型AI「Lp-Convolution」がコンピュータビジョンを変革

2025年4月22日、基礎科学研究所(IBS)、延世大学、マックスプランク研究所の研究チームが、機械視覚を人間の脳の画像処理方法に近づける新しい人工知能技術「Lp-Convolution(エルピー・コンボリューション)」を開発したと発表しました。この技術は、画像認識システムの精度と効率を向上させると同時に、既存のAIモデルの計算負荷を軽減します。

Lp-Convolutionの革新性

従来の畳み込みニューラルネットワーク(CNN)は、画像処理に小さな正方形のフィルターを使用していましたが、これは柔軟性に欠けるアプローチでした。Lp-Convolutionは、多変量p一般化正規分布(MPND)を使用してCNNフィルターを動的に再形成する新しい方法を採用しています。

従来のCNNが固定された正方形のフィルターを使用するのに対し、Lp-Convolutionはタスクに基づいて水平方向や垂直方向にフィルター形状を適応的に変更できます。これは、人間の脳が選択的に関連する詳細に焦点を当てる方法に似ています。

この技術革新により、「大きなカーネル問題」として知られるAI研究の長年の課題が解決されました。単にCNNのフィルターサイズを大きくしても(例:7×7以上のカーネル)、より多くのパラメータを追加しているにもかかわらず、通常はパフォーマンスが向上しません。Lp-Convolutionは、生物学的にインスパイアされた柔軟な接続パターンを導入することでこの限界を克服しています。

実践的な性能向上

標準的な画像分類データセット(CIFAR-100、TinyImageNet)でのテストでは、Lp-ConvolutionはAlexNetのような古典的モデルからRepLKNetのような最新アーキテクチャまで、精度を大幅に向上させました。

この研究は国際学習表現会議(ICLR)2025で発表され、研究チームはコードとモデルを公開しています。これにより、他の研究者や開発者がこの技術を活用して、より効率的で正確な画像認識システムを構築できるようになりました。

解説:なぜこれが重要なのか

脳型AIの開発は、単なる性能向上だけでなく、より少ないエネルギーと計算リソースでより優れた結果を得ることを目指しています。人間の脳は非常に効率的にエネルギーを使用し、複雑なタスクを実行します。Lp-Convolutionのような技術は、AIモデルをこの効率性に近づける一歩です。

従来のAIモデルでは、画像内の特定のパターンを認識するために膨大な計算リソースが必要でしたが、人間の脳はより少ないエネルギーで素早く正確に物体を認識できます。Lp-Convolutionは、この「脳のような」処理を模倣することで、コンピュータビジョンの効率と精度を向上させています。

これにより、自動運転車、医療画像診断、監視システムなど、リアルタイムの画像認識が必要なアプリケーションが大幅に改善される可能性があります。例えば、医療分野では、より少ないコンピューティングリソースでより正確なMRIやCTスキャンの分析が可能になるかもしれません。

ロボットがHow-to動画から学習する「RHyME」フレームワーク

2025年4月22日、コーネル大学の研究者たちが、ロボットが単一のハウツー動画を見るだけでタスクを学習できる新しいロボットフレームワーク「RHyME(Retrieval for Hybrid Imitation under Mismatched Execution:不一致実行下のハイブリッド模倣のための検索)」を開発したと発表しました。この技術はロボットシステムの開発と展開を加速させ、トレーニングに必要な時間、エネルギー、コストを大幅に削減する可能性があります。

RHyMEの革新性

従来のロボット学習では、人間とロボットの動きの間に少しでも違いがあると、学習方法が完全に機能しなくなっていました。RHyMEは、人間とロボットがタスクを実行する方法の「不一致」に対処する原則的な方法を提供します。

RHyMEは、ロボットがより柔軟で適応力のあるシステムになるための拡張可能なアプローチです。ロボットが以前に見た動画から着想を得て、一度見ただけのタスクを実行する際に「ドット」を結びつけるために独自のメモリを使用できるようにします。

例えば、人間がカウンターからマグカップを取って近くのシンクに置く動画を見せられたRHyME搭載ロボットは、カップを掴んだり食器を下げたりするような類似のアクションから着想を得るために、自身の動画バンクを検索します。

実用的なメリット

RHyMEは、ロボットがわずか30分のロボットデータで学習でき、研究室環境では、RHyMEを使用してトレーニングされたロボットは以前の方法と比較してタスクの成功率が50%以上向上しました。

RHyMEは、ロボットがマルチステップのシーケンスを学習できるようにし、トレーニングに必要なロボットデータ量を大幅に削減します。

解説:なぜこれが重要なのか

ロボットに新しいタスクを教えることは、従来は非常に時間とリソースを消費するプロセスでした。コードを手動で書いたり、ロボットに一連の動きを細かく教えたりする必要がありました。模倣学習のアプローチにより、ロボットは人間の動きを観察し、それを模倣することでより自然にスキルを獲得できます。

しかし、人間とロボットの身体構造や動き方の違いが大きな障壁となっていました。RHyMEの革新的な点は、この「実行の不一致」問題を解決することです。人間の動きをそのまま模倣するのではなく、タスクの本質を理解し、ロボット自身の能力に合わせた方法でそれを実行する方法を学習できます。

これにより、家庭用ロボット、工場のオートメーション、医療補助ロボットなど、様々な分野でのロボット応用が加速する可能性があります。例えば、パンデミックや人手不足の際に、様々なタスクを素早く学習できるロボットが重要な役割を果たすことができるでしょう。

脳信号を自然な音声にリアルタイム変換する画期的技術

2025年3月31日、カリフォルニア大学バークレー校とカリフォルニア大学サンフランシスコ校(UCSF)の研究チームが、重度の麻痺患者のために自然な発話を回復させる方法を開発したことを発表しました。この研究は、音声ニューロプロステーシス(脳から音声への変換技術)におけるレイテンシー(遅延)の長年の課題を解決します。

技術の革新性

新しいストリーミング方式により、被験者が話そうとしている瞬間にほぼリアルタイムで聞こえる出力を生成できます。研究者らは音声検出方法を使用してレイテンシーを測定し、話し始めの脳信号を特定することができました。

「私たちのストリーミングアプローチは、AlexaやSiriのような迅速な音声デコーディング能力をニューロプロステーシスにもたらします」と、カリフォルニア大学バークレー校のゴパラ・アヌマンチパリ助教授は述べています。

この技術は、最近の人工知能ベースのモデリングの進歩を活用して、脳信号を聞き取り可能な音声にほぼリアルタイムで合成するストリーミング方法を開発しました。これにより、話す能力を失った人々のコミュニケーションを可能にする重要な一歩となります。

実用的な進歩

以前のBCI研究では、1つの文章をデコードするのに約8秒の長いレイテンシーがありました。新しいストリーミングアプローチでは、被験者が話そうとしている瞬間にほぼリアルタイムで聞こえる出力を生成できます。

「意図信号に対して、1秒以内に最初の音を出すことができます」とアヌマンチパリ教授は述べています。「そして、このデバイスは音声を連続的にデコードできるので、アン(被験者)は中断することなく話し続けることができます。」

この速度向上は精度を犠牲にすることなく実現されており、高速インターフェースは以前の非ストリーミング方式と同じレベルのデコード精度を提供します。

解説:なぜこれが重要なのか

自然な会話はリアルタイムで行われるものです。話そうとしてから実際に音声が出るまでに数秒以上の遅延があると、会話の自然な流れが妨げられます。脳卒中や神経疾患で発話能力を失った人々にとって、このような遅延は意味のある対話への参加を困難にし、孤立感やフラストレーションにつながる可能性があります。

この新しい技術は、脳の表面から高密度で記録された神経信号を使用して、連続的にストリーミングする自然な音声合成器を駆動します。研究チームは、80ミリ秒ごとに神経活動をデコードして、個人に合わせた流暢な音声合成を実現するディープラーニングモデルを設計しました。

これにより、重度の麻痺や発語不能(無発語症)の患者が、より自然なコミュニケーションを取り戻すことができる可能性があります。例えば、家族との会話、医療従事者への要望の伝達、あるいは単に社会的な交流への参加など、生活の質を大きく向上させることが期待されます。

AI技術の今後の発展と私たちの生活への影響

これらの最新のAI技術革新は、それぞれ独自の方法で人間の能力を模倣し、拡張しています。Lp-Convolutionは人間の視覚システムの選択的注意メカニズムを模倣し、RHyMEはロボットに人間の動きから学習する能力を与え、脳-音声ニューロプロステーシスは脳信号を自然な音声に変換します。

医療分野での応用

特に医療分野では、これらの技術の影響が顕著になる可能性があります。Lp-Convolutionは医療画像診断の精度を向上させ、RHyMEはリハビリテーションロボットや介護ロボットの能力を高め、脳-音声インターフェースは発話障害を持つ患者にコミュニケーション能力を回復させる可能性があります。

このような技術の組み合わせにより、例えば、脳卒中後の患者が思考でロボット補助器具を制御しながら、自然な音声でコミュニケーションを取るといった総合的なリハビリテーションシステムが実現する可能性もあります。

日常生活への統合

これらの技術は、より広い社会への導入も期待されています。例えば、Lp-Convolutionのように効率的な画像認識技術は、スマートフォンのカメラ機能やAR(拡張現実)アプリケーションの性能を向上させる可能性があります。

RHyMEのような模倣学習技術は、家庭用ロボットや産業用ロボットがYouTubeのハウツー動画から新しいスキルを学習できるようになる未来を示唆しています。将来的には、一般ユーザーが自分の家事ロボットに特定のタスクを実演して教えることもできるようになるかもしれません。

倫理的考慮と課題

これらの技術の発展に伴い、プライバシー、セキュリティ、アクセシビリティなどの倫理的考慮事項も重要になってきます。特に脳信号を読み取る技術は、思考のプライバシーに関する新たな疑問を提起します。

また、これらの高度な技術へのアクセスが公平であることを確保し、技術格差を拡大しないための対策も必要です。特に医療技術については、必要とする全ての人々がアクセスできるようにするための取り組みが求められます。

まとめ

2025年の最新AI技術は、人間の脳の機能をより深く理解し、それを模倣することで大きく前進しています。Lp-Convolution、RHyME、脳-音声ニューロプロステーシスはいずれも、人間の自然な能力に着想を得た革新的なアプローチです。

これらの技術は、医療、コミュニケーション、自動化などの分野に革命をもたらす可能性を秘めており、今後数年でさらなる発展が期待されます。AI研究が進むにつれて、人間とAIの協力関係はさらに深まり、より自然で直感的なインターフェースが実現するでしょう。

テクノロジーの急速な進化に伴い、私たちはこれらのツールを責任を持って開発し、社会全体の利益のために活用する方法を考え続ける必要があります。最終的には、これらの技術革新は、障害を持つ人々の生活の質を向上させ、私たち全員の日常生活をより便利で効率的にする可能性を秘めています。

解説:Lp-Convolutionとは?

Lp-Convolutionは、従来の畳み込みニューラルネットワーク(CNN)の改良版と考えることができます。CNNは画像認識などのタスクで広く使用されていますが、そのフィルターは常に正方形の形状に限定されていました。

Lp-Convolutionの革新的な点は、タスクに応じてフィルターの形状を動的に変更できることです。例えば、横長の物体を検出する場合は横長のフィルター、縦長の物体には縦長のフィルターというように、認識対象に合わせて最適な形状に適応します。

これは人間の視覚野の働きに似ています。私たちの脳は、見ている対象に応じて、関連する視覚情報に選択的に注意を向けることができます。Lp-Convolutionはこの柔軟性を模倣しており、結果としてより効率的かつ精度の高い画像認識が可能になります。

解説:RHyMEの仕組み

RHyMEフレームワークは、ロボットが人間のデモンストレーションから学習する「模倣学習」の新しいアプローチです。従来の模倣学習では、人間とロボットの動きの違いが大きな課題でした。

RHyMEの核心は「シーケンスレベルの類似性」という概念にあります。個々の動きは人間とロボットで異なるかもしれませんが、タスク全体のシーケンスレベルでは類似性を見出すことができるという考え方です。

具体的には、最適輸送(Optimal Transport)というアルゴリズムを使用して、人間の動作シーケンスとロボットの動作シーケンス間の類似性を測定します。そして、ロボットの動画と人間の動画のデータベースを使って、意味的に同等の人間の動きを合成します。

このアプローチにより、ロボットは人間の動きを直接模倣するのではなく、タスクの本質を理解し、自身の能力に合わせた方法でそれを実行することを学習します。

解説:脳-音声ニューロプロステーシスの仕組み

脳-音声ニューロプロステーシスは、発話に関連する脳の運動野から信号を検出し、それを音声に変換する技術です。この技術は以下のステップで機能します:

- 高密度電極アレイを使用して、脳の音声運動野から神経活動を記録します。

- これらの信号は80ミリ秒ごとに分析され、ディープラーニングの再帰型ニューラルネットワークトランスデューサーモデルによって処理されます。

- モデルは脳信号を音声の低次元表現(バーク周波数ケプストラル係数、ピッチ、有声性など)にマッピングします。

- これらのパラメータはボコーダー(音声合成器)に入力され、聞き取り可能な音声が生成されます。

最も革新的な点は、このプロセス全体がほぼリアルタイムで行われ、話そうとしてから音声が生成されるまでの遅延がわずか1秒未満であることです。これにより、自然な会話のリズムが維持され、より自然なコミュニケーションが可能になります。

また、このシステムは学習することで精度が向上し、トレーニングデータセットの語彙にない単語も正確に合成できることが示されています。これは、システムが単純に単語を丸暗記しているのではなく、音声の構成要素(音素など)を本当に理解していることを示唆しています。